国际多媒体顶级学术会议(ACM MM2021)论文接收名录公开!淘系技术内容互动算法团队4篇论文入选!恭喜恭喜~

国际多媒体学术会议(ACM MM)是计算机学科公认的多媒体领域和计算机视觉领域的国际顶级会议,也是中国计算机学会(CCF)推荐的A类国际学术会议。ACM MM研究领域覆盖图像、视频、音频、人机交互、社交媒体等多个主题,本次 ACM MM2021 一共收到 1,942 篇论文申请,最终入选 542 篇论文(约 27.9% 的接受率)。

淘系技术部内容互动算法团队,聚焦机器学习、视觉算法、NLP算法,端侧智能等领域,依托淘系数十亿级的视频数据,业务上支持淘宝直播、逛逛和点淘,有丰富的业务场景和技术方向,不断探索和衍生颠覆型互联网新技术,团队成员来自海内外知名高校,近两年参加CVPR竞赛获得4项冠军,累积在计算机视觉顶会期刊(如CVPR、TPAMI、TIP等)上发表论文10余篇,技术成果获得国家科技进步二等奖。

本次 ACM MM2021 会议,该团队一共 4 篇论文被接收,并有相关技术创新点在淘系业务场景中的应用。后文将详细介绍各篇论文创新点以及落地使用。

NO.1

题目

Understanding Chinese Video and Language via Contrastive Multimodal Pre-Training

基于对比多模态预训练理解中文视频和文本

作者

雷陈奕,罗时现,刘勇,何旺贵,王家忙,王国鑫,唐海红,苗春燕,李厚强

论文创新点&对于行业的影响

预训练模型在自然语言处理领域、视觉领域乃至多模态领域已经取得了巨大的成功。本文聚焦于多模态领域中的视频-文本的联合预训练策略,尤其针对中文视频和文本。针对视频-文本进行预训练主要存在以下挑战:第一,和静态图像不同,视频拥有动态的时空序列关系,直接将图像-文本的预训练方法移植到视频-文本领域并不足以捕捉这些复杂的关系信息;第二,预训练模型中广泛存在的视频-文本对齐任务和其它基于掩码的重建任务存在冲突;第三,大规模、高质量的中文视频-文本数据集的缺乏限制了预训练模型在中文领域的发展。

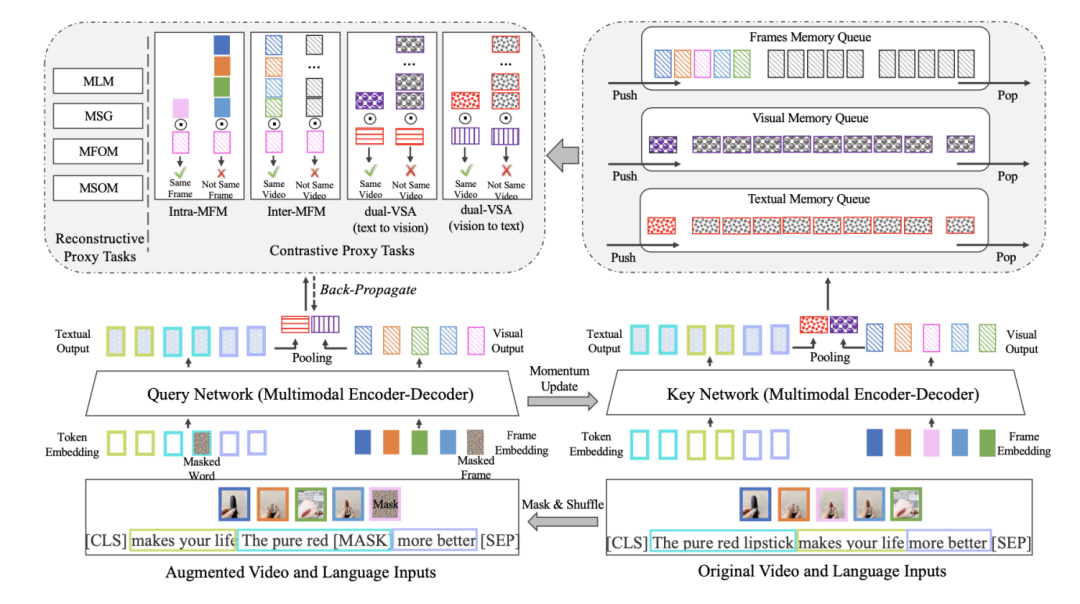

由此,本文提出一个基于重建和对比学习任务的多模态预训练模型VICTOR,并建立千万数量级的高质量中文视频-文本数据集。VICTOR以Transformer为主体,设计出基于重建和基于对比学习的七个任务训练模型。基于重建的任务包括掩码语言建模、掩玛句子生成、掩码帧序列建模和掩码句子序列建模四个任务,充分捕捉视频和文本的序列信息和交互信息;基于对比的任务包括对偶的视频-文本对齐、视频内的掩码帧对比学习和视频间的掩码帧对比学习三个任务,在避免简单的视频-文本对齐任务会融合不确定的多模态信息的同时,增强视频内的时空信息融合。VICTOR模型拥有上亿级参数,在构造的千万数量级的淘系视频-文本数据集中进行预训练,并在多个下游任务(如视频文本匹配、视频推荐、标题生成)获得了SOTA的性能提升。VICTOR模型的设计和提出,有效促进了预训练在中文视频-文本领域的进展,并可在多个视频相关业务(如视频推荐、视频分类等)广泛应用。

Victor 模型的总体框架:包含模型设计和自监督任务

论文相关技术在淘系实际场景的应用

我们将VICTOR预训练的视频特征应用到内容检索、推荐、分类、直播等多个领域。各个应用场景均对比场景中已服务的Strong Baseline,具体来说:

- 内容推荐--逛逛内容推荐。效率保持稳定下,3天新发内容占比提升22.81%,冷启动UCTR +4.29%, PCTR +4.72%;

- 内容检索--淘宝经验。跨模态检索,保障相关性评测基础下,无结果率由3.23%降至0.95%

- 内容分类--逛逛内容分类。图文分类精度相对提升3.94%(60.97%->63.37%),视频分类精度相对提升7.33%(51.99%->55.80%)

- 物体检测与匹配 -- 直播看点审核。全品类检测精度相对提升4.83%(89%->93.3%),美妆难例检测精度相对提升8.05%(75.8%->81.9%)

论文阅读/下载链接

https://arxiv.org/abs/2104.09411

NO.2

题目

Pre-training Graph Transformer with MultimodalSide Information for Recommendation

用于推荐系统的融合多模态信息的图预训练Transformer

作者

刘勇,杨粟森,雷陈奕,王国鑫,唐海红,张举勇,孙爱欣,苗春燕

论文创新点&对于行业的影响

在个性化推荐领域,尤其是短视频的推荐领域,多模态信息发挥着重要的作用。有效利用item的多模态信息,如文本、视觉等信息,可有效提高推荐的性能,缓解冷启动问题。目前存在的融合多模态信息的推荐模型,都是端对端的基于特定任务的模态融合,消耗资源的同时限制了模型的泛化。另外,在推荐领域,item之间存在着各种相关性(如基于标签的语义相关、基于行为的用户兴趣相关等)。为节省资源,提高模型利用率,同时捕捉item之间的相关性,本文提出一种基于多模态信息融合的图预训练框架PMGT,在捕捉item相关性的同时,指导item多模态信息的融合,并且预训练后的item特征,可应用到多种下游任务,避免了在每个特定任务都要重新融合模态信息的资源浪费和时间消耗。

PMGT首先根据item的相关信息,构建出一个item多模态图,其中图的节点为item,边反应了item之间的关系(如被相同用户交互过的item建立边),每个节点的特征由item的多模态特征构成。对图中的每个节点,我们设计出高效并行的采样方法MCNSampling,从图中采样出若干与其相关的节点组成节点序列,并使用基于多样性的transformer框架聚合节点特征,缓解模态融合的冗余性。最后使用基于图结构重建的任务和基于节点特征重建的任务指导相关节点融合和节点自身的多模态信息融合。将PMGT在Amazon和MovieLens公开数据集上预训练并测试,和最新的图预训练模型相比,达到SOTA性能。PMGT使用图的方式指导item的多模态信息的融合,并有效捕捉item之间的相关性,让预训练并不局限于item自身,增强了预训练的item特征的表达能力,可适用于多种下游任务和领域。

论文相关技术在淘系实际场景的应用

在淘系的短视频推荐领域,我们基于短视频tag信息建立拥有400万节点、4亿边的视频多模态图,并将PMGT预训练后的特征直接应用到短视频的召回阶段,7天新内容占比提升7%。之后可将预训练特征应用到排序阶段,甚至其它的业务场景(如视频分类),并且可将PMGT作为基础框架,使用特定的任务微调模型,达到效果的进一步提升。

论文阅读/下载链接

https://arxiv.org/abs/2010.12284

NO.3

题目

Shape Controllable Virtual Try-on for Underwear Models

(SC-VTON:针对内衣模特的形状可控的虚拟试衣系统)

作者

高鑫,刘振江,冯尊磊,申成吉,欧开日,唐海红,宋明黎

论文创新点&对于行业的影响

我们提出了一种形状可控的虚拟试衣网络(SC-VTON),针对内衣模特的试衣任务,使用融合了模特和服饰信息的GAT网络来生成形变后的服饰图片。除此之外,我们在SC-VTON中加入控制点来达到服饰的形状控制。更进一步,通过增加Splitting Network和Synthesis Network,我们可以使用服饰-模特的pair对数据优化模型,同时将任务泛化到常规的2D虚拟试衣任务。我们的方法能够做到精准的服饰形状控制。同时与其他方案相比,我们的方案能够生成纹理逼真的高分辨率图片,并且能够在实际应用中落地。这是业内首个将图注意力网络应用到虚拟试衣任务,同时能够做到精准可控的服饰形变。

论文相关技术在淘系实际场景的应用

服饰是淘系最重要的类目,虚拟试衣作为一种新颖的互动展示方式,为用户带来创新体验,为商家创造新的品牌展示方式。从20年元旦开在手淘拍立淘、扫一扫、云主题等公域场景上线了"虚拟试衣间"产品: 提供不同身材的模特供用户挑选,支持几十万件服饰的在线实时试穿。"虚拟试衣间" PV20-30W,UV10W,二跳页人均停留时长2min,平均试衣件数12件。此外,运营同学利用虚拟试衣产品功能,在微博发起"一天试穿500件奢侈品"话题营销活动,曝光2.4亿,讨论量15.1万,产品得到了商家和线上用户认可。

论文阅读/下载链接

https://arxiv.org/pdf/2107.13156.pdf

NO.4

题目

TransRefer3D: Entity-and-Relation Aware Transformer for Fine-Grained 3D Visual Grounding

(TransRefer3D:基于实体-关系可知的Transformer模型的细粒度3D视觉指代定位)

作者

何岱岚,赵禹昇,罗钧宇,惠天瑞,黄少飞,张爱喜,刘偲

论文创新点&对于行业的影响

本文提出了一种基于Transformer的模型来抽取3D场景中物体之间的多模态上下文,从而建模更具判别力的特征来定位被指代物体。

该模型的每一层中主要包括两个模块:

- 实体可知的注意力模块。该模块将语言中的实体信息与视觉实体特征相匹配,提取符合语言描述的实体特征;

- 关系可知的注意力模块。该模块将语言中的关系信息与视觉实体间成对的关系特征进行匹配,增强符合关系描述的实体特征。该模型在两个细粒度3D视觉指代定位基准数据集上取得了当前最优效果。

论文相关技术在淘系实际场景的应用

细粒度3D视觉指代定位任务目前在淘系业务中没有实际应用,未来可在视频结构化信息提取、智能机器人控制和人机交互等方面有广泛的潜在应用场景。本文所提出的模型可以辅助智能机器人更好地理解人类用户的指示语言与视觉信息的对应关系,从而在真实的3D场景中对物体实现准确的定位,为下游的复杂任务提供技术基础。

论文阅读/下载链接

http://colalab.org/media/paper/mm21_transrefer3d_camera_ready.pdf

结语

获得以上论文收录的淘宝内容互动算法团队,负责淘宝直播、视频和图文以及评价UGC的内容业务的算法研发,利用前沿的人工智能技术在内容业务上的知识挖掘,理解,认知,表示学习,智能剪辑和内容生成等课题和研究方向来打造阿里巴巴内容算法平台。

目前,该团队在大规模多模态预训练模型,多媒体内容的结构化和数字化,融合行业领域运营知识的内容图谱的构建,用户内容消费兴趣表征和认知推荐和内容创意的生成与互动(智能看点,智能摘要,合辑生成,虚拟试衣,3D直播间,虚拟主播等)等技术方向持续深耕。希望通过不断加深对用户在淘宝全域的兴趣理解和实时的感知,在内容领域建立起完善的分类和属性的标签体系,细到物品,场景,人物属性和声音风格,粗到内容类型,拍摄手法,泛化到内容的各层次的表征学习等多粒度的内容认知,实现内容的通用表征学习,提升多媒体内容搜索和推荐匹配的极致效率和体验,让淘宝成为消费者购买决策第一阵地,同时热烈欢迎对课题和方向有兴趣的同学的加入。